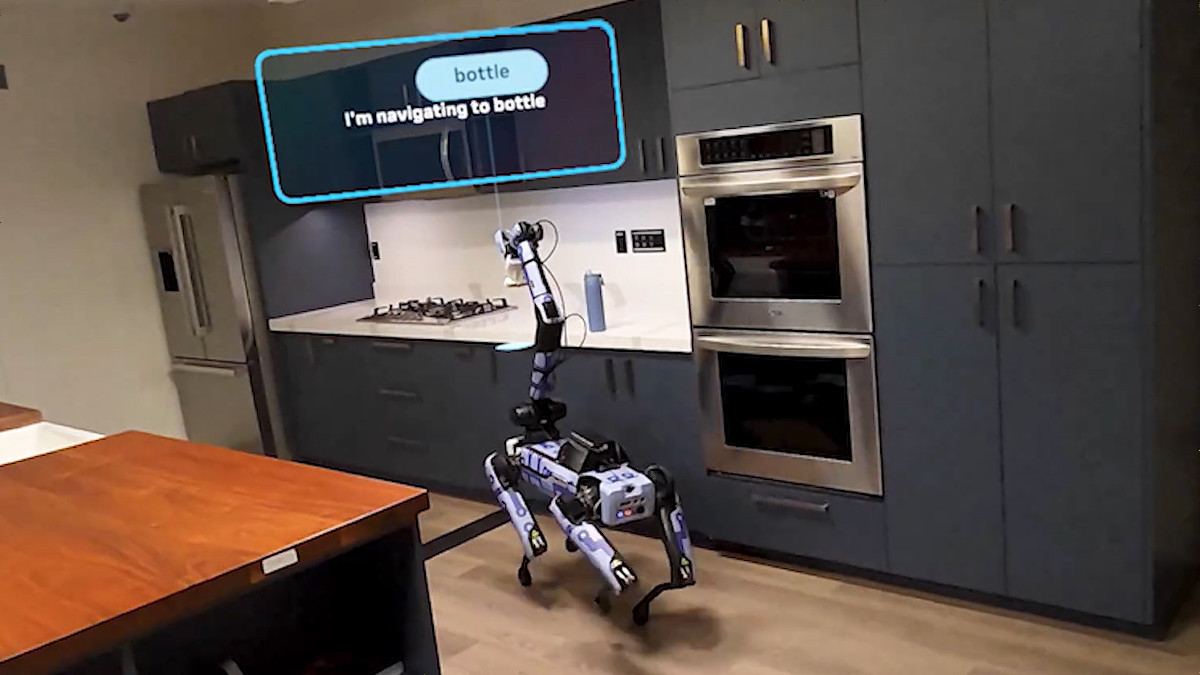

Metaが賢いロボットを作るためのAIモデル「V-JEPA 2」をリリース、物理学的に正しい推論が可能で「考えてから行動するロボット」の開発に役立つ

Metaが物理学的に正しい推論が可能なAIモデル「V-JEPA 2」をリリースしました。V-JEPA 2は現実世界の事象を記録した動画でトレーニングされており、「周囲の状況を元に次に発生する事象を推論して行動できるロボット」の開発に役立つとされています。

Introducing V-JEPA 2

https://ai.meta.com/vjepa/Introducing the V-JEPA 2 world model and new benchmarks for physical reasoning

https://ai.meta.com/blog/v-jepa-2-world-model-benchmarks/ 人間は「混雑した道を人や障害物を避けながら歩く」「ボールを投げて落下地点を予測する」といったように物理学的な事象を直感的に予測しながら行動することができます。Metaは人間と同様に「物理世界を理解して、自らの行動に対する反応を予測しながら行動する」という能力を持った「高度な機械知能(advanced machine intelligence :AMI)」の実現を最終目標に掲げており、AMIを実現するべく物理学的に正しい理解・予測・計画が可能な「世界モデル(world model)」の開発を進めています。 今回リリースされたV-JEPA 2は「最先端の世界モデル」に位置付けられたAIモデルです。V-JEPA 2のトレーニングは2段階に分かれており、1段階目では「料理が完成したら皿を手に取る」といった現実世界の事象を記録した100万時間以上の動画を用いてトレーニングされ、「現在の状況から未来の状況を推論する能力」を得ることに成功しました。トレーニングの2段階目ではロボットアームの稼働状況を記録した動画データセット「DROID」に含まれる合計62時間の動画を学習し、「目標に達成のための行動を計画する能力」を獲得しました。

最終的に、V-JEPA 2はパラメータ数12億のAIモデルとなりました。V-JEPA 2が1つの行動計画に必要な時間は「NVIDIA Cosmos」の30分の1で、既存のモデルと比べて圧倒的に高速な推論が可能。また、「未知の環境で未知の物体を拾って配置する」というタスクでは65~80%という高い成功率を記録しました。

V-JEPA 2と既存モデルの性能比較表が以下。V-JEPA 2は「計画」「予測」「理解」の3分野で既存モデルを上回る性能を発揮しました。

V-JEPA 2のモデルデータは以下のリンク先で配布されています。

V-JEPA 2 - a facebook Collection

https://huggingface.co/collections/facebook/v-jepa-2-6841bad8413014e185b497a6また、V-JEPA 2の構築に必要なコードなどは以下のGitHubリポジトリで公開されています。

GitHub - facebookresearch/vjepa2: PyTorch code and models for VJEPA2 self-supervised learning from video.

https://github.com/facebookresearch/vjepa2さらに、MetaはAIモデルが物理世界をどれだけ正確に理解および推論できるかを測定できるベンチマーク3種を公開しました。3種の名前と概要は以下の通りです。

AIモデルに「途中まで同じ内容で、途中から片方は物理的に正しい動き、もう片方は物理的に誤った動きを記録した1組の動画」を入力し、どちらが物理学的に正しい動画か判断させるテスト。AIモデルの「物理的に正しい動きの認識能力」を評価できる。 選択問題を提示して、AIモデルの物理的な理解能力を評価する。表面的な手掛かりやバイアスに頼る近道的な解決策を回避できるように設計されている。 映像言語モデルの「物理的な因果関係に関する質問に応じる能力」を評価できる。 上記の3種のベンチマークは人間なら85~95%の精度で正確に回答できるものの、V-JEPA 2を含む既存モデルの正答率は人間と比べて圧倒的に低いとのこと。Metaはこれらのベンチマークでも高スコアを記録できるAIモデルの開発を目指しています。・関連記事 動画を「見て」学習するアーキテクチャ「V-JEPA」をMetaが開発 - GIGAZINE

30分の学習で動かせる激安219ドルのAIロボットアーム「Navrim」が登場 - GIGAZINE

AI操作の自律型ドローンが国際レースで初めて人間のチャンピオンに勝利、人間と同じたった1つのカメラで飛行 - GIGAZINE

Hugging Faceがオープンソースのヒューマノイドロボット「HopeJR」とデスクトップユニット「Reachy Mini」を発表 - GIGAZINE

物を拾い上げたり置いたりできるプログラム可能でオープンソースのロボットアーム「SO-101」をHugging Faceが発表 - GIGAZINE

NVIDIAが人型ロボット用オープン基盤モデル「Isaac GR00T N1」を発表、多様な環境で動作する汎用ロボットの開発に役立つ - GIGAZINE

Googleがロボット工学用のAIモデル「Gemini Robotics」をリリース、口頭で指示するだけでロボットがタスクをやってくれる - GIGAZINE