AIの小規模言語モデル(SLM)に研究者たちが送る熱視線

プルーニングの着想源となったのは、現実のニューラルネットワーク(神経回路網)、すなわち人間の脳である。脳は、その人が歳を重ねるとともにシナプスの接続を断ち切っていくことで、パフォーマンスの効率を高めていく。

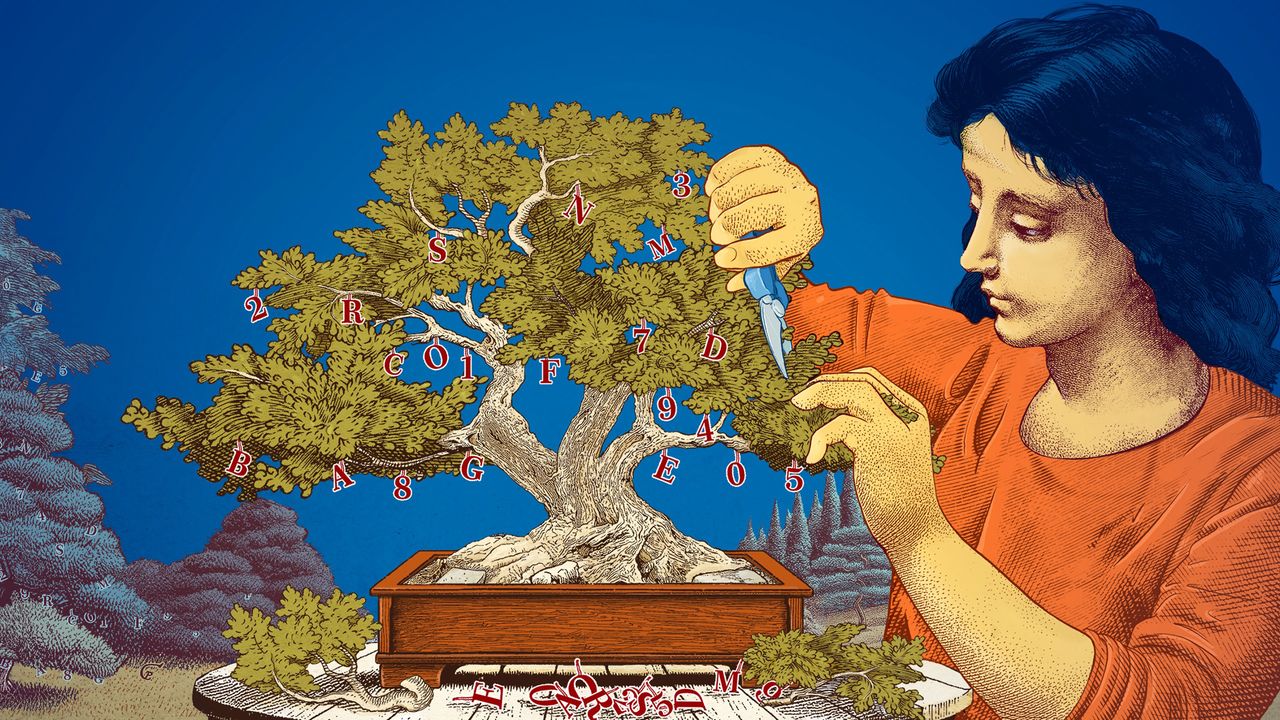

今日のプルーニングという考え方は、現在メタにいるコンピューターサイエンティストのヤン・ルカンが1989年に発表した論文にまで遡る。そこで主張されていたのは、機械学習したニューラルネットワークがもっているパラメーターのうち最大90%までを取り除いても、その性能は損なわれないということだった。

関連記事:メタでチーフAIサイエンティストを務めるヤン・ルカンへのインタビューはこちら

ルカンは、この方法論を「最適な脳細胞死(Optimal Brain Damage)」と呼んだ。プルーニングは、小規模言語モデルを特定のタスクや環境に合わせて微調整していくに際して、研究者たちの助けとなるのだ。

言語モデルの仕組みに興味をもっている研究者たちは、小規模モデルを活用して、斬新なアイデアを廉価に試すことができる。また、大規模モデルに比べてパラメーター数が少ないがゆえに、小規模モデルの論理的思考の仕組みはよりわかりやすいものと考えられる。

「新しいAIモデルをつくるには、いろんなことを試さねばなりません」と話すのは、MIT-IBM Watson AIラボのレシェム・チョーシェンだ。「小規模モデルを使えば、研究者たちは大きなリスクを負うことなく実験できるのです」

パラメーター数が増えていく一方の大規模で高価なモデルは、汎用チャットボット、画像生成、そして創薬といっ