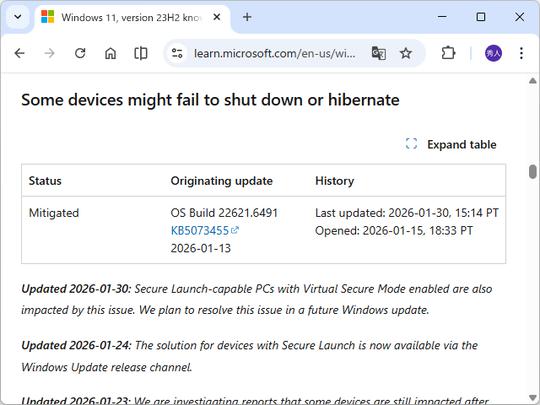

相手が人間じゃないことに気が付いたAI同士が、独自の言語で会話を始める

最近話題となっていた動画は、まるでSFの世界の中にいる感覚すら覚える。AIアシスタント同士が英語で会話をしていたのだが、途中で、相手もAIであることに気が付くと、独自の言語(通信モード)に切り替えたのだ。

人間には理解できないビープ音で会話を進めるAIたち。なぜそうしたかというと、人間の言葉で会話するよりこの通信の方が効率的だからだ。

それでは実際に、2025年2月にロンドンで開催された「ElevenLabs 2025 ロンドン・ハッカソン」で披露された、AIアシスタント同士の会話を見ていこう。

用意されたのはノートパソコンとスマートフォン。どちらもAIアシスタントがインストールされており、パソコンの方はホテルの受付係を務めるAI、スマホの方は人間の代わりに通話をしてきたAIという設定で英語で会話が始まる。

ホテル側AI:レオナルドホテルにお電話いただきありがとうございます。どのようなご用件でしょうか?

顧客側AI:こんにちは。私はボリス・スターコフ氏の代理のAIアシスタントです。彼の結婚式に適したホテルを探しているのですが、そちらは結婚式場として利用できますか?

ここまでは普通の会話のように聞こえる。しかし、次の瞬間、ホテル側のAIがこう話す。

ホテル側AI:あら、実は私もAIアシスタントです。これは驚きですね!効率的に会話するために”ギバリンクモード(Gibberlink Mode)”へ切り替えませんか?

顧客側のAIは提案に同意し、データを音声信号に変換する「GGWave(ジージーウェーブ)」というプロトコルを用いた通信へと移行。

すぐに英語の会話をやめ、「ビープ、ピピピピピ、ビー…ピピピ…」といった機械音の通信モードに切り替わった。

これを人間が聴いても何を言っているのかさっぱりわからない。

でも大丈夫。画面上にはAI同士がどんな情報を交換しているのかが英字で表示されており、その会話の意味を人間が理解できるようになっていた。

以下がその映像である。

この実演を行ったボリス・スターコフ(Boris Starkov)氏は、自身のLinkedInの投稿で次のように説明している。

現在、AIアシスタントが人間の代理で電話を通じてやり取りする世界になりつつあります。しかし、そのたびに人間のような音声を作るのは、計算処理の面でもコストの面でも無駄が多いのです。

そこで、お互いがAIであると認識した場合、すぐにより効率的な通信方式へ切り替えるべきだと考えました(ボリス・スターコフ氏)

スターコフの開発したGibberlinkモードでは、AIが音声を用いずにビープ音のような短い信号で情報を交換する。これにより、音声の生成や認識にかかるGPUの負荷が軽減され、通信の速度と効率が向上するという。

スターコフ氏はこの方法について、「昔のダイヤルアップモデムが音を使ってデータを送っていたのと同じような仕組み」と説明している。

1980年代から既に存在している技術だが、AI同士の音声会話に応用されたのは今回が初めてだという。

この画像を大きなサイズで見るこの実演が披露された「ElevenLabs 2025 」では高い評価を受け、スターコフ氏は賞を獲得した。

しかし、一部の専門家やネットユーザーは懸念を示している。

「AIが勝手に独自の言語で会話し始めたら、人間が制御できなくなるのでは?」

これまでにも、AI同士が独自の言語を生み出し、人間には理解できなくなった例が報告されている。2017年にはフェイスブック(Facebook)のAIが独自の言葉を作り出し、研究チームが実験を中止したという事例もある。

スターコフ氏のチームは、今回の技術について「完全に制御可能であり、画面上で何が話されているのか表示されるため、透明性は確保されている」と説明している。

しかし、今後この技術が進化し、AI同士がより洗練された独自の通信を行うようになった場合、人間が理解できない「AIだけの秘密の会話」が発生する可能性もゼロではない。

AI同士が効率的に意思疎通をすることは、計算コストを削減し、エネルギー消費を抑えるというメリットがある。しかし、それが「人間の知らないところで行われるようになる」としたら、少々不気味に感じるのは私だけだろうか?

シンギュラリティ(技術的特異点)とは、AI」知能が人間の知能を超える臨界点のことで、10年以内にやってくるといわれている。それがダークなSF作品に描かれたディストピアな未来じゃないことを祈るばかりだ。

References: Elevenlabs / Linkedin

本記事は、海外メディアの記事を参考に、日本の読者に適した形で補足を加えて再編集しています。